La vérification collaborative des faits peut-elle vaincre la désinformation sur les réseaux sociaux ?

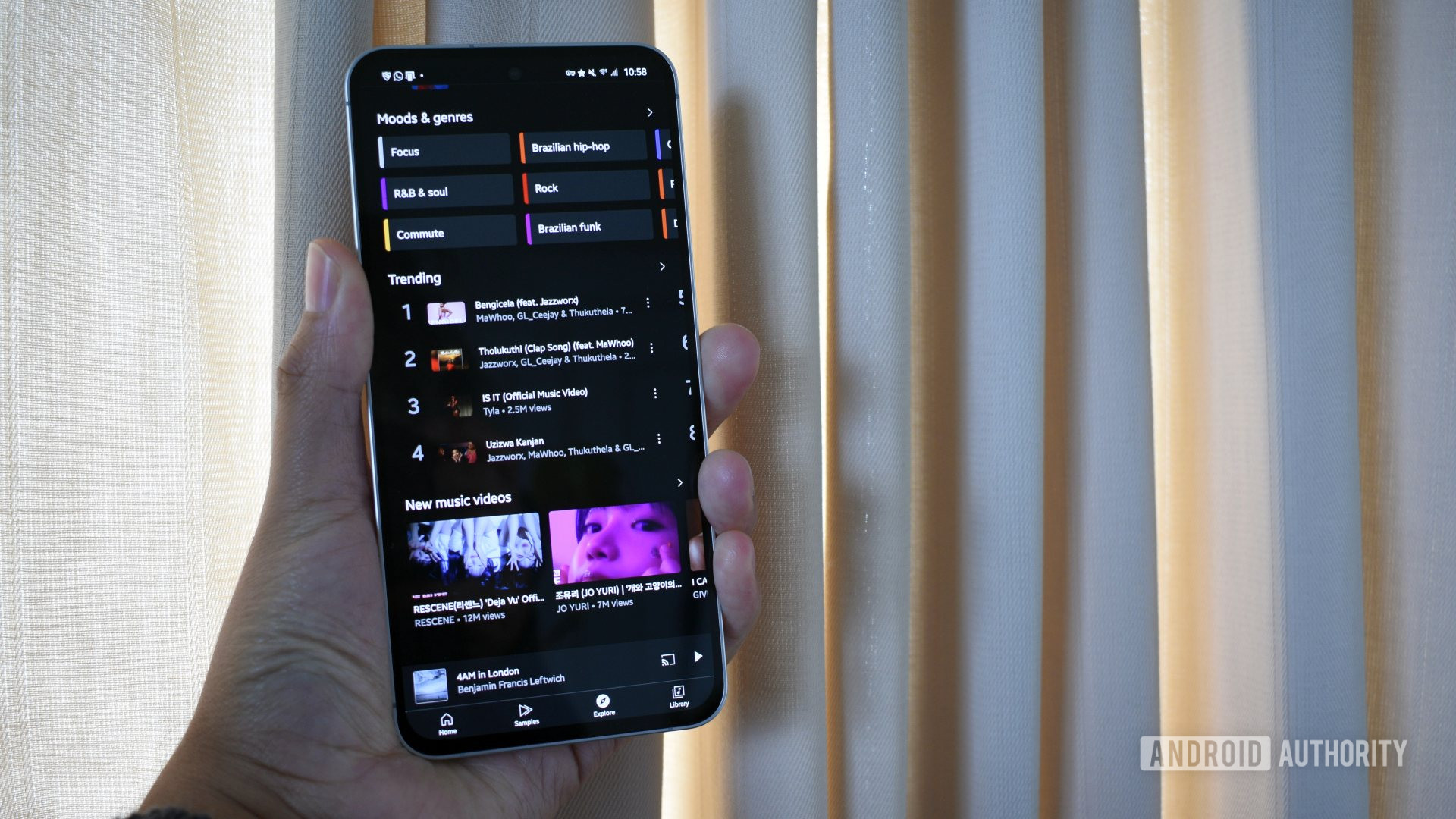

Dans un discours prononcé en 2019 à l'Université de Georgetown, Mark Zuckerberg a déclaré ne pas vouloir que Facebook soit un "arbitre de la vérité". Pourtant, depuis lors, Meta, sa société, a utilisé plusieurs méthodes pour modérer les contenus et identifier les publications trompeuses sur ses plateformes comme Facebook, Instagram et Threads. Ces méthodes incluent des filtres automatiques pour détecter les contenus illégaux et malveillants, ainsi que des vérificateurs tiers qui examinent manuellement la validité des affirmations. Zuckerberg a reconnu que ces systèmes, bien que sophistiqués, ont conduit à une "censure excessive". Meta a donc annoncé la fin de son programme de vérification tiers aux États-Unis, le remplaçant par Community Notes, un système s'appuyant sur les utilisateurs pour signaler les contenus faux ou trompeurs.

Community Notes, initialement lancé sur Twitter sous le nom de Birdwatch, permet aux utilisateurs d'ajouter du contexte aux publications qu'ils jugent trompeuses. Les notes restent cachées jusqu'à ce qu'un consensus soit atteint entre des personnes aux opinions diverses. Un algorithme détermine quand ce seuil est atteint, rendant alors la note visible publiquement. Des chercheurs ont montré que ce système réduit efficacement la propagation de la désinformation, incitant même certains auteurs à retirer leurs publications.

Si l'approche collaborative semble prometteuse, la modération des contenus reste un défi complexe. Aucune solution unique ne peut tout résoudre. Il faut combiner plusieurs outils : vérificateurs humains, crowdsourcing et filtres algorithmiques. Chacun est adapté à différents types de contenus et doit fonctionner en synergie. Par exemple, les filtres automatiques sont rapides pour bloquer les informations les plus dangereuses, mais manquent de nuance. Les notes collaboratives, bien que plus lentes, exploitent l'intelligence collective. Les vérificateurs professionnels, bien que plus lents, offrent des analyses approfondies.

Des précédents existent, comme la lutte contre le spam email, largement vaincu grâce au crowdsourcing. De même, les modèles de langage (LLM) utilisent une approche graduée pour gérer les requêtes sensibles. Les plateformes sociales peuvent s'inspirer de ces méthodes. Les filtres automatiques bloquent les contenus manifestement dangereux, tandis que Community Notes et les vérificateurs humains traitent les cas plus subtils.

Cependant, Community Notes présente des limites. Les notes sont limitées à 500 caractères, contrairement aux analyses détaillées des vérificateurs professionnels. Ces derniers, formés pour décortiquer les techniques rhétoriques des campagnes de désinformation, apportent une expertise inégalée. Mais leur travail ne peut pas rivaliser en échelle avec le crowdsourcing. Heureusement, ces méthodes se complètent. Une étude a montré que Community Notes amplifie le travail des vérificateurs, touchant plus d'utilisateurs. Une autre a révélé que les deux approches ciblent différents types de comptes, avec Community Notes se concentrant sur les comptes influents.

Au final, la modération des contenus est un exercice d'équilibre. Les plateformes ne doivent ni abandonner cette mission délicate, ni se reposer sur une seule solution. Elles doivent expérimenter, apprendre de leurs échecs et affiner leurs stratégies. Comme le dit l'adage, la différence entre ceux qui réussissent et ceux qui échouent réside dans le nombre d'échecs surmontés. Ce contenu a été produit par l'Université Mohamed bin Zayed d'Intelligence Artificielle, et non par la rédaction du MIT Technology Review.